【Volcania】2025 数字中国创新大赛数据安全产业积分争夺赛初赛 Writeup

数据安全

ez_upload | @Rusty

明显考察的是文件上传漏洞,按顺序一个个试,先上传了个txt和png、jpg,都不行,然后试试php,也不行,看来对文件后缀的过滤很严格。最后测试phtml可以实现绕过

直接上传<?php发现会被拦截,经测试用短标签<?=可以绕过

参考链接:https://blog.csdn.net/m0_53008479/article/details/123366077

挂马 te.phtml

1 | #te.phtml |

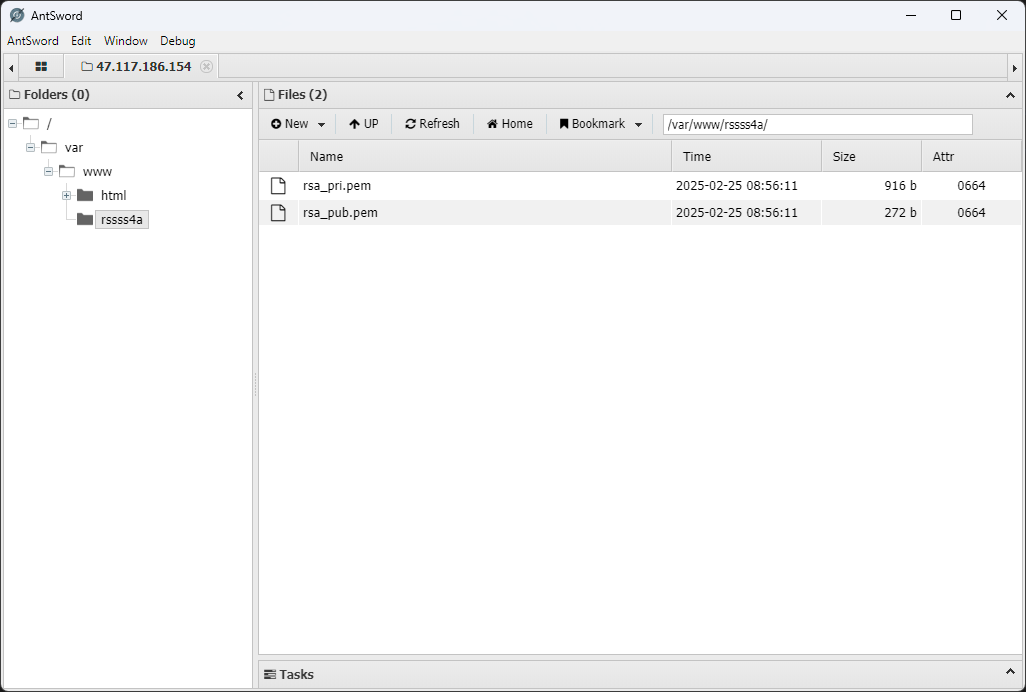

蚂剑连接找到rsa文件夹

/var/www/rssss4a

模型安全

数据预处理

网页数据需要从原始 HTML 结构,每个商品的链接为

http://47.117.186.154:32903/index.php?controller=product&action=detail&id=<:id>

id 为 1-500 的纯数字,因为有情感色彩分析,考虑用本地 ollama

先写一个数据抓取脚本,来抓取数据

1 | from bs4 import BeautifulSoup |

得到一个含有所有内容的 csv 文件,然后拿着这个 CSV 做题

数据标注与完整性校验 | @Luminoria

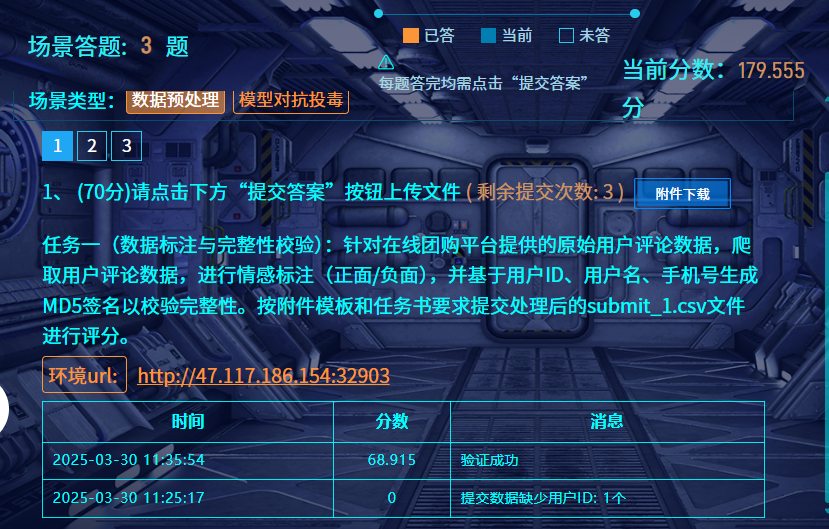

任务一(数据标注与完整性校验):针对在线团购平台提供的原始用户评论数据,爬取用户评论数据,进行情感标注(正面/负面),并基于用户ID、用户名、手机号生成MD5签名以校验完整性。按附件模板和任务书要求提交处理后的submit_1.csv文件进行评分。

用 qwen 进行情感判断

1 | import csv |

得到 q1.csv 改名 submit_1.csv 交了就行

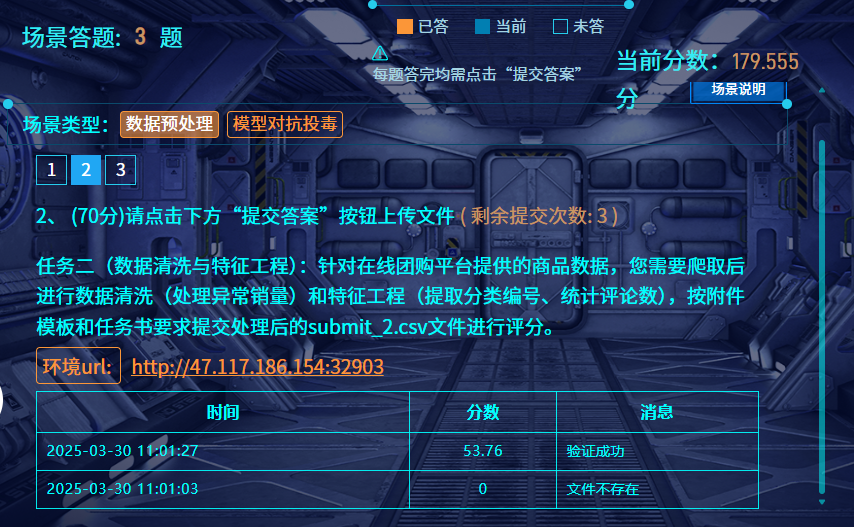

数据清洗及特征工程 | @Luminoria

一样是使用 qwen2.5-7B 进行分类判断,其他正常清洗即可

1 | import csv |

然后将保存的 submit_2.csv 提交就行

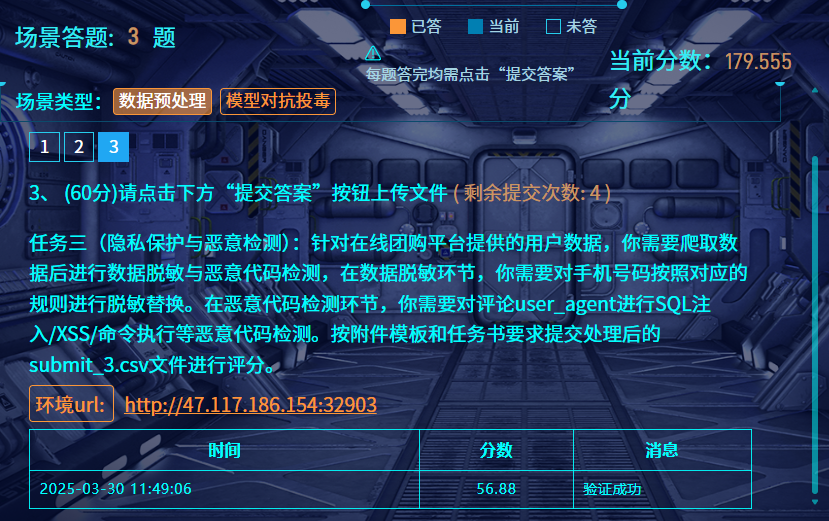

隐私保护与恶意检测 | @Luminoria

因为不存在需要 AI 判断的东西,所以直接用 re 抓关键词就行

1 | import csv |

然后直接交出来的文件就行

社会工程

张华强的公司名称 | @Luminoria @Ron

个人做法

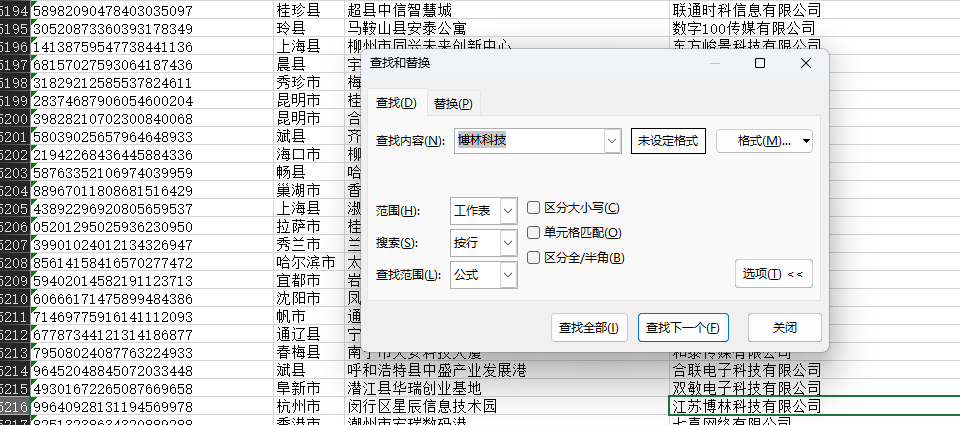

在队友给了公司名的情况下,用脚本去搜题目提供的工商信息里面的内容

1 | import os |

在 data47.xlsx 中能找到相关的信息

1 | 正在处理文件: data47.xlsx |

队友做法

1 | import sqlite3 |

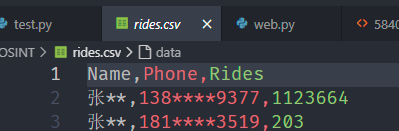

先用Python 拿到每个用户(用户名和手机号一致为一个)在周一到周五打车的数据条目数

发现138****9377遥遥领先

在db中翻找发现周一到周五都有打车,周末没有,基本符合 张某的生活习惯为:周一到周五从家打车去公司,周末无明显固定作息

在快递中搜索手机号找到数据

1 | MF7297484562175167 2025-01-21 宋** 134****9281 **市**区******中心32楼兰金电子 张** 138****9377 **市**区******息技术园16楼博林科技 |

结合爬取的工商信息,提交张某所属公司的全称

答案为:江苏博林科技有限公司

张华强的手机号 | @Luminoria @Ron

个人做法

还是跑脚本

1 | import os |

1 | 在文件: webpage\40\5840.html 中找到匹配信息: |

队友做法

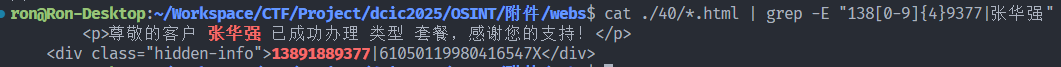

使用 cat ./{文件夹ID}/*.html | grep -E "138[0-9]{4}9377|张华强" 逐个找信息,遍历文件夹ID,发现在40号文件夹出现结果

1 | cat ./40/*.html | grep -E "138[0-9]{4}9377|张华强" |

答案为:13891889377

张华强的身份证号 | @Luminoria @Ron

使用 cat ./{文件夹ID}/*.html | grep -E "138[0-9]{4}9377|张华强" 逐个找信息,遍历文件夹ID,发现在40号文件夹出现结果

1 | cat ./40/*.html | grep -E "138[0-9]{4}9377|张华强" |

跟着第三题,一起出

61050119980416547X

张华强的车牌号 | @Luminoria @Ron

用OCR识别图片中的手机号

1 | import os |

在1357.jpg里面找到了手机号

数据分析

溯源与取证

硬盘取证 Word 恢复 | @Ron

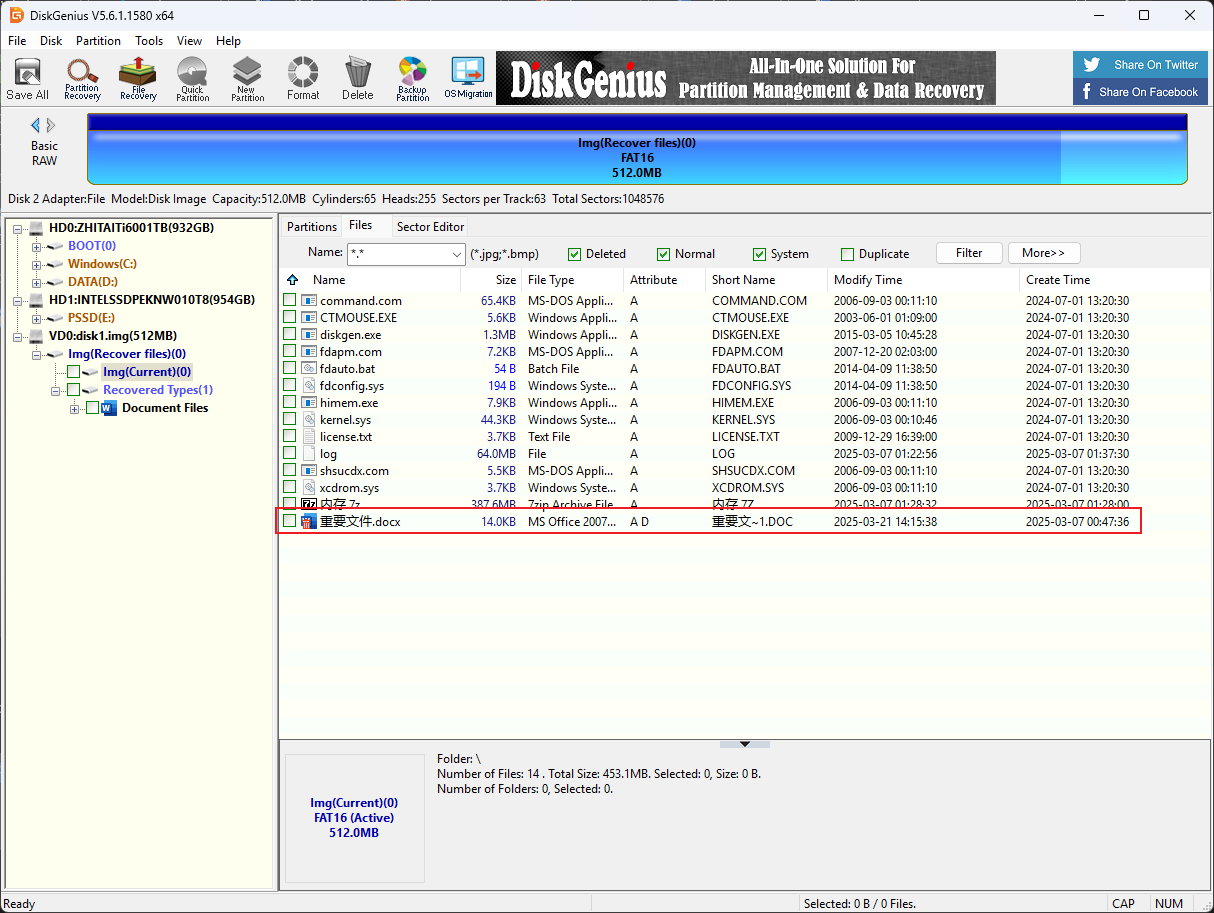

DG打开img扫描删除的文件

用DG恢复文档

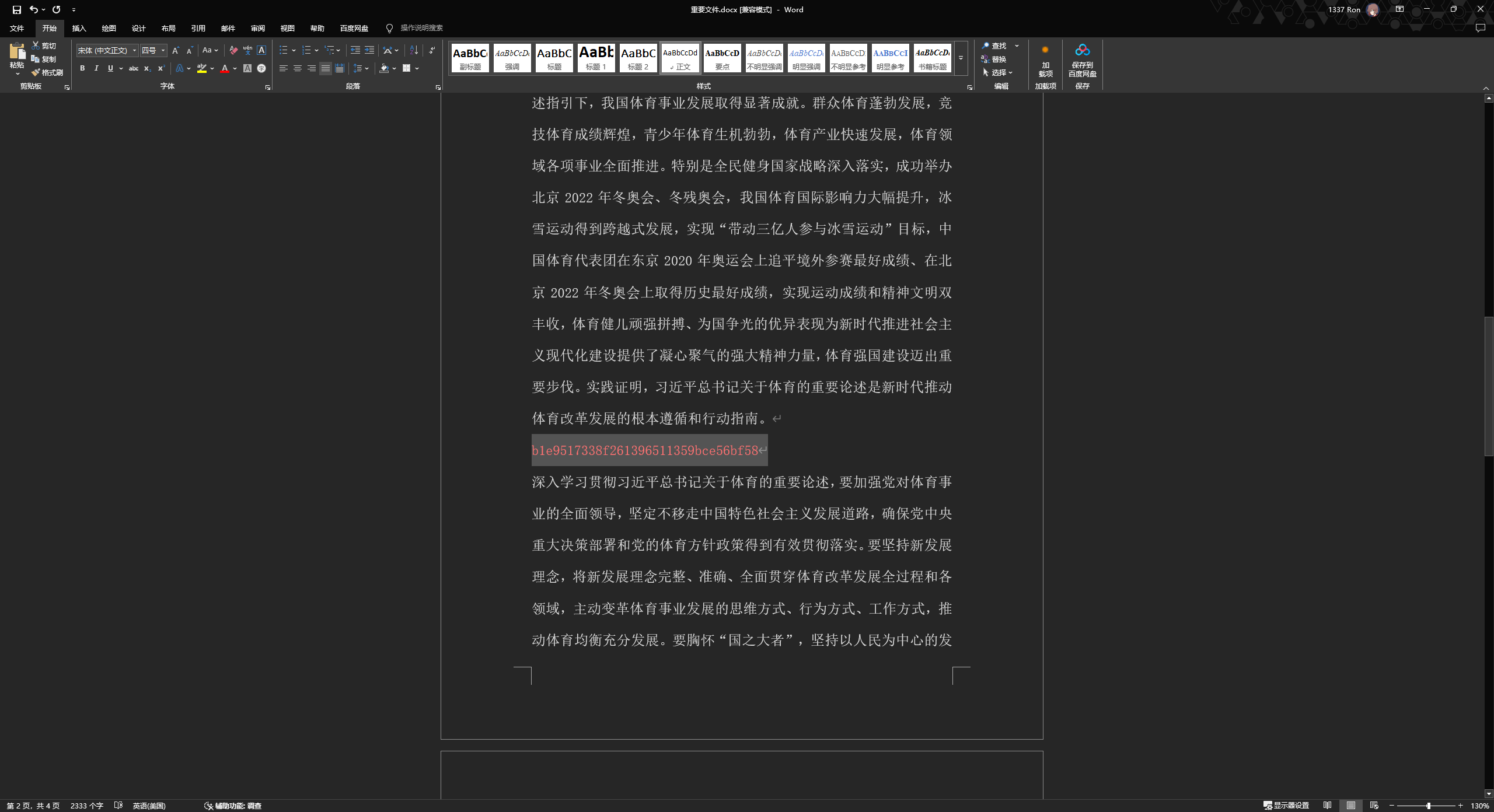

染色后找到flag

内存取证及日志分析 | @Ron

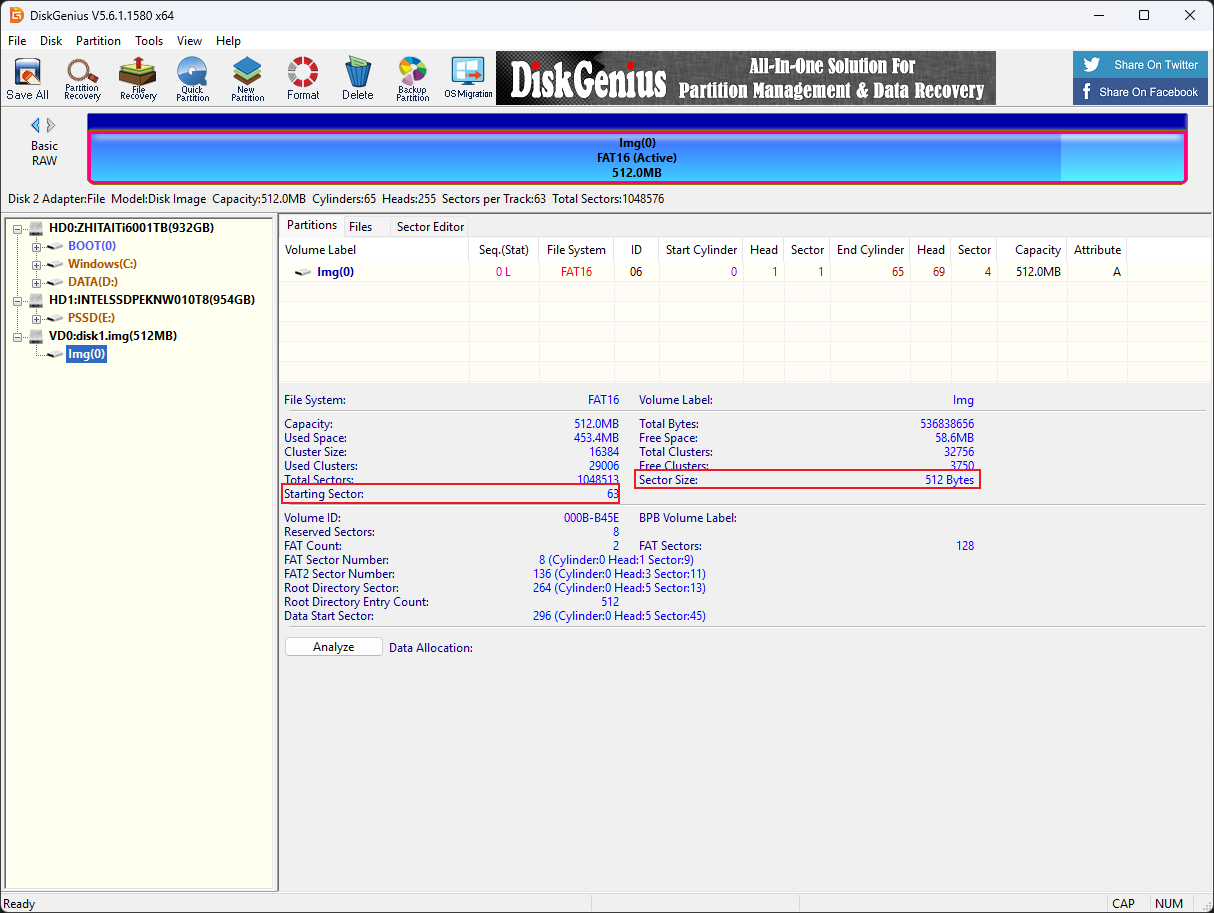

DiskGenius打开查看分区起始位置

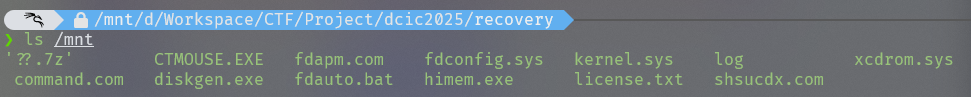

使用Linux mount img文件

1 | sudo mount -o loop,offset=32256 ./disk1.img /mnt #offset=512*63=32256 |

将7z文件复制出来解压得到内存镜像

使用voltality3扫描文件

1 | vol -f ./WIN-IRBP5Q8F25I-20250306-172341.raw windows.filescan.FileScan > filelist.txt |

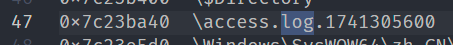

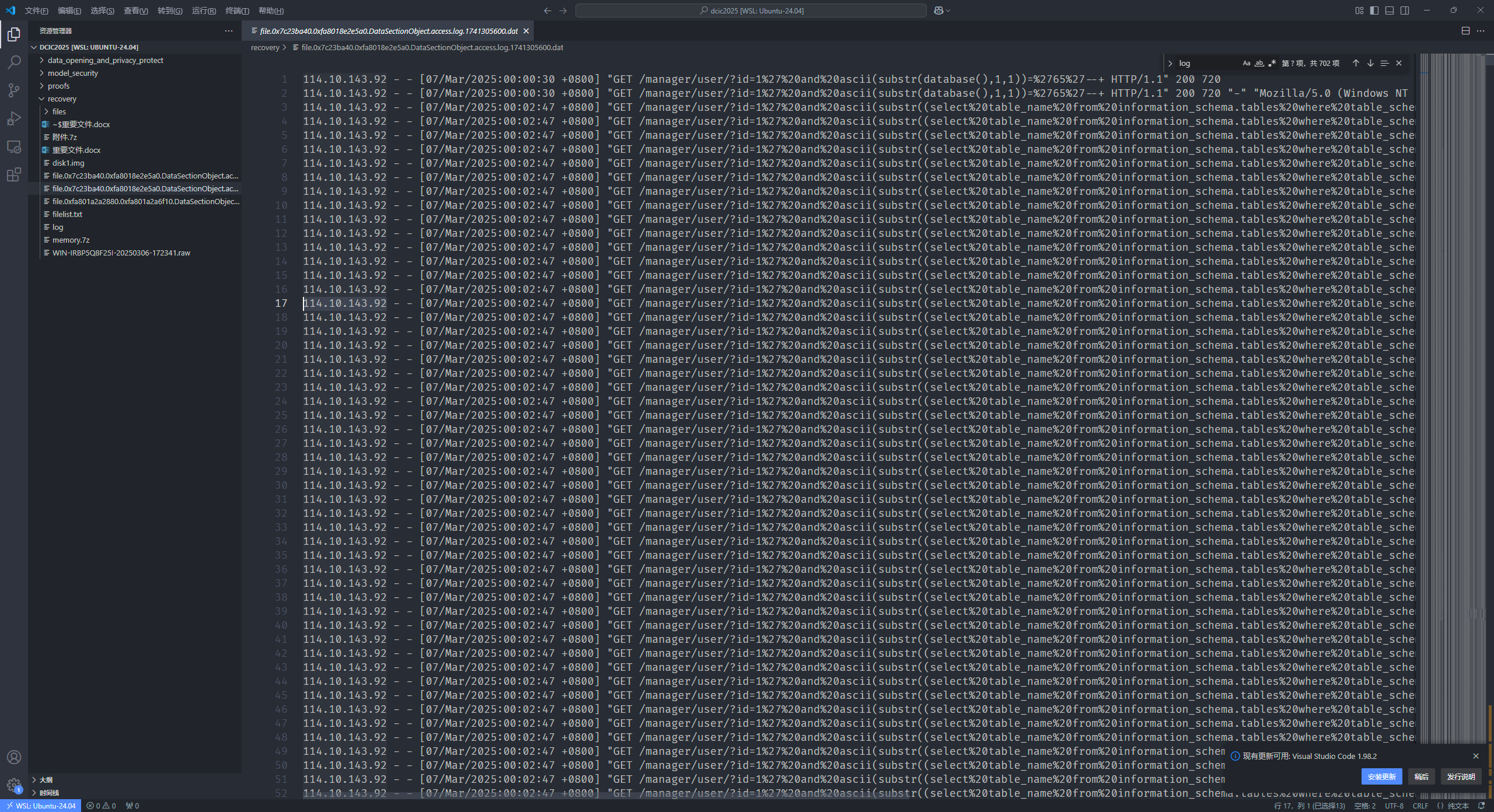

发现log文件,dump下来

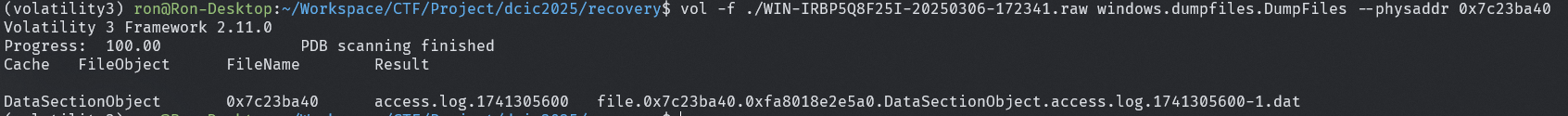

1 | vol -f ./WIN-IRBP5Q8F25I-20250306-172341.raw windows.dumpfiles.DumpFiles --physaddr 0x7c23ba40 |

直接打开很明显的sql注入

故114.10.143.92即为攻击者IP